[DL/ Attention] 어텐션_기본개념

- 어텐션을 가장 잘 설명하는 느낌이랄까? (attention을 공부하면서 듣기 좋다!)

들어가기에 앞서

- 이글은 Context(문맥으로 순화)를 다루기 위한 방법 중, 하나로 모든 기억을 동등하게 기억하지 안고 연관성 있는 기억에 집중해서, 기억하도록 구조화 하는 방법인 어텐션에 대해서 다룬다.

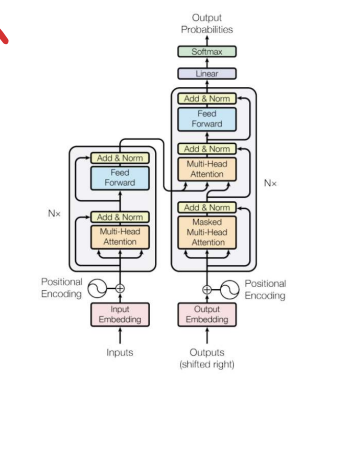

- 어텐션 초기 모델은 순환 구조에 어텐션을 결합한 형태였지만, but! 최근 모델에서는 순환 구조를 배제하고 어텐션 계층과 완전 연결 계층만을 사용하여 만들어짐!

(질문 - 이게 Transformer인가요?)

어텐션(attention)

- attention 이란 뇌가 가장 중요하고 연관성 있는 정보에 집중하는 것을 말한다.(ex 중요한 단어에 동그라미 치고 밑줄쳐서 집중하는 느낌), 중요하다고 판단되는 부분에 집중하고 나머지는 계략적으로 본다.

- 이러한 것은 뇌가 상황을 빠르게 판단하기 위해 '꼭 필요한 정보만 취하려는' 생물학적 기제 떄문이다.

그럼 이런한 어텐션으로 무엇을 할수 있을까?

1) 언어 모델의 어텐션 활용

- 언어 모델에 어텐션을 적용한다면, 문장의 특정한 단어를 볼떄, 문장 내의 다른 단어와의 연관성을 어텐션값(attention Value)로 사용한다.

- 위의 그림을 예시 로 설명 하자먄, eating 과 apple/ green 과 apple 서로 연관성이 있음으로 강한 연관을 갖는다. 하지만 green 과 eating은 연관성이 없는 단어 이므로, 낮은 연관성을 같게 되어서, 낮은 어텐션을 갖게 되는 것이다.

2) 어텐션 계산을 위한 쿼리와 (키,값의 목록)

- 이러한 어텐션의 개념에 대해서 알았다면, 앞서 설명한 것 처럼 언어 모델에서 이를 이용하기 위해, 어텐션값(attention Value)을 사용한다.

- 쿼리는 (나는) 이라는 주체가 Qurey가 되고, 연관성을 찾는 대상인 ( l , love, her)이 key, 가 되며, 이런 Q 와 K의 유사성을 계산하여 유사한 만큼의 Value 값을 가져 올 수 있게 되는 것이다.

- 따라서 앞으로는 어텐션은 Q, K, V를 반환하는 하나의 함수라고 생각하자!

주의!!!

Q / K / V의 대상은 같고, 다만 안의 숫자값만 다름에 유의할 것!!! ( 그림을 인코더 쪽에서 보 면 디코더쪽 정보가 넘어올 수 없다!!!!)

디코더쪽이라고 해도,,,,,,인코더쪽의 Q/K가 넘 어가는 것이라서...그림이 틀림!!!!

3) 어텐션 점수의 종류

아직 이해 부족